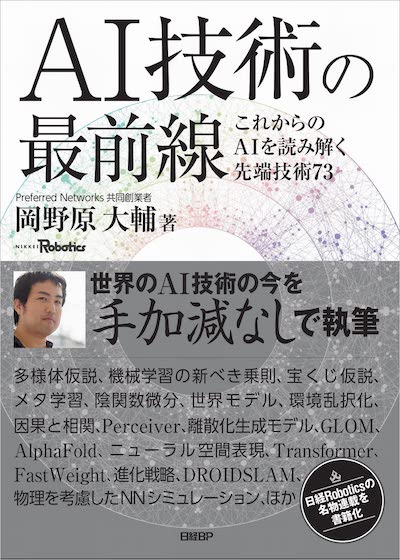

このサイトは「AI技術の最前線 - これからのAIを読み解く先端技術73」に関する情報、訂正情報などを掲載します。誤りやコメントがありましたら サポートメール宛に送っていただけたら幸いです。

本書について #

この本は「日経Robotics」誌に2015年7月から毎月連載している「AI最前線」を加筆・修正し一つの冊子にまとめたものです。AIに関する73の注目技術について紹介しています。

書誌情報 #

- タイトル:AI技術の最前線 - これからのAIを読み解く先端技術73

- 著者:岡野原 大輔

- 出版社:日経BP

- ページ数:224ページ

- Amazon / 楽天ブックス / honto / ヨドバシ.com

お知らせ #

- 2022/8/4 AI技術の最前線 紙版 電子版販売開始します

- 2022/7/27 サポートページをオープンしました。

AI技術の最前線 目次一覧 #

- 第1部 知能とは何か、ディープラーニングとは何か

- 第1章 原理解明に向けた動き

- 1-1 なぜディープラーニングがうまく学習できるのか

- 1-2 多様体仮説:現実世界のデータをどうモデル化するか

- 1-3 なぜディープニューラルネットは汎化するのか

- 1-4 独立成分分析:情報のもつれを解く

- 1-5 ディープラーニングの理論解析:ニューラルネットの未解決問題の解明へ大きく前進

- 1-6 過剰パラメータ表現のニューラルネットワークと宝くじ仮説

- 1-7 因果と相関:未知の分布まで汎化できるか

- 1-8 対称性は学習にどのように活かせられるか

- 1-9 機械学習の新べき乗則:大きなモデルを使うと汎化しサンプル効率も改善する

- 1-10 頑健なモデルには過剰パラメータ表現が必要

- 第2章 人の学習

- 2-1 脳内で誤差逆伝播法が起きているか?

- 2-2 脳の学習システム:Learning system in brain

- 第1章 原理解明に向けた動き

- 第2部 学習手法

- 第3章 学習手法

- 3-1 学習のエンジン:数理最適化 Adagrad、RMSProp、Adam

- 3-2 乱択化フーリエ特徴関数:大規模問題でもカーネル法を適用可能に

- 3-3 正則化:汎化能力をどのように手に入れられるか

- 3-4 誤差逆伝播法による期待値最大化

- 3-5 誤差逆伝播法を使わない学習手法 Feedback Alignment、Synthetic Gradient、Target Prop

- 3-6 継続学習:過去の学習結果を忘れずに新しいタスクを学習できるか

- 3-7 予測学習:Predictive Learning

- 3-8 進化戦略:Evolution Strategy

- 3-9 メタ学習:学習の仕方を学習するMAMLやNeural Process

- 3-10 陰関数微分:勾配計算で計算グラフをワープする

- 3-11 教師なし表現学習:異なるビュー間の相互情報量最大化

- 3-12 知識蒸留:巨大なモデルの知識を抽出する

- 3-13 Masked Autoencoder:画像認識でも事前学習革命は起きるのか

- 第4章 強化学習

- 4-1 強化学習:フィードバックから最適行動を獲得する

- 4-2 世界モデル:world model、想像の中で学習できるか

- 4-3 安全が保証された強化学習:リアプノフ関数で制約満たす方策を導出

- 4-4 先読みに基づいたプランニング:学習化シミュレータとモンテカルロ木探索

- 4-5 オフライン強化学習:データ主導型学習に向けて

- 第5章 高速化・低電力化・インフラ

- 5-1 ディープニューラルネットの学習をどこまで速くできるのか

- 5-2 モバイル向けのニューラルネットワーク:推論時の電力効率を高める3つの方策

- 5-3 AI研究の苦い教訓

- 5-4 MN-3/MN-Core:世界で最も省電力性能に優れたスーパーコンピュータ

- 第3章 学習手法

- 第3部 モデルとアーキテクチャ

- 第6章 生成モデル

- 6-1 Generative Adversarial Networks:ニューラルネットを競合させ生成モデルを鍛える

- 6-2 Variational Walkback:再帰確率的ニューラルネットで生成、認識を行う

- 6-3 Glow:可逆な生成モデル、GANより安定的に学習できる尤度ベースの手法

- 6-4 自己注意機構:Self-Attention、画像生成や機械翻訳など多くの問題で最高精度

- 6-5 連続ダイナミクスを表現可能なニューラルネットワーク

- 6-6 正規化層:ニューラルネットワークの学習の安定化、高速化、汎化に大きな貢献

- 6-7 Energy-Based Model:ノイズを復元して生成モデルを学習する

- 6-8 Transformer:全タスクの標準ネットワークアーキテクチャになるか

- 6-9 離散化生成モデル

- 6-10 Perceiver:多様な入出力に対応可能なニューラルネットワーク

- 第7章 記憶の仕組み

- 7-1 “Fast Weight”:アテンションで短期記憶を実現する

- 7-2 Differentiable Neural Computers:外部記憶を備えたニューラルネットワーク

- 第6章 生成モデル

- 第4部 アプリケーション

- 第8章 画像

- 8-1 画像認識で大きな成果上げるCNN:分類のエラー率は1年ごとに半分近くに減少

- 8-2 GLOM:パース木による画像認識の実現を目指して

- 第9章 音声

- 9-1 WaveNet:自然な音声や音楽を生成可能なニューラルネットワーク

- 第10章 空間生成/認識

- 10-1 Generative Query Network:画像から3次元構造を理解し生成する

- 10-2 自己教師あり学習による深度と自己移動の推定

- 10-3 3次元形状をどのように表現するか

- 10-4 画像からの3次元シーン理解に向けた局所特徴量に基づく画像マッチング

- 10-5 人や動物の空間理解の仕組みをAIに活かせるか

- 10-6 Rotation Averaging:高速かつ最適な姿勢推定を実現する

- 10-7 DROID-SLAM:逐次的な修正で環境に対応する

- 10-8 Neural Descriptor Fields:少数教師からの学習を可能とする物体や3次元環境の同変表現

- 第11 章 言語

- 11-1 seq2seq:文から文を生成するニューラルネットワーク

- 11-2 言語の創発:機械はどのようにコミュニケーションできるのか

- 11-3 自由な言葉でロボットに指示をする:Unconstrained Spoken Language Instruction for robots

- 11-4 BERT:言語理解の事前学習

- 第12章 制御

- 12-1 確率的制御:不正確な制御が学習を助ける

- 12-2 オンライン学習と最適制御、未知ノイズにも頑健な制御手法

- 第13章 シミュレーション

- 13-1 AIによるシミュレーションの進化

- 13-2 シミュレーションに基づく推論:観測からパラメータを帰納的に推定する

- 13-3 深層学習を使った物理シミュレーションの高速化

- 13-4 AIを使った汎用原子レベルシミュレーター Matlantis

- 第14章 ゲーム

- 14-1 AlphaGo:CNNと強化学習を組み合わせたコンピュータ囲碁

- 14-2 AlphaGo Zero:ゼロから学習で人を超える

- 14-3 AlphaStar:多様性のある学習環境で高度なスキルを獲得

- 第15章 バイオ・生命科学

- 15-1 AlphaFold:50年間の生命科学のグランドチャレンジを解く

- 第16章 ロボット

- 16-1 全自動の片付けロボットシステムをいかに開発したか、高精度な物体認識により初めて片付けが可能に

- 16-2 環境乱択化:Domain Randomization

- 第8章 画像